fot. YouTube

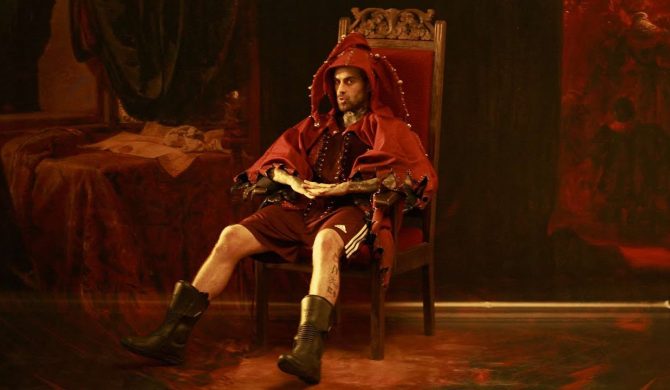

Mijający tydzień to w polskiej muzyce przede wszystkim nowy singiel Quebonafide. Utwór „Futurama 3 (fanserwis)” od czwartku zgromadził już blisko 2 mln wyświetleń na YouTubie, na Spotify licznik pokazuje aktualnie ponad 1,1 mln.

Fani rapera są wniebowzięci i zachwycają się nie tylko samym kawałkiem, ale także towarzyszącym mu klipem autorstwa Andrzeja Dragana. Twórca chętnie korzystał w pracy z dobrodziejstw generatywnej sztucznej inteligencji, o czym opowiedział we wpisach na platformie X.

– Wszystkie tła scenograficzne z nowego klipu dla Quebo generowałem w Midjourney. Do tego masa ujęć lub przejść w Runwayu, Lumie i Stable Diffusion skalowane oczywiście Topazem. No i deep fejki na specjalnie trenowanych GANach. Dzięki temu można było zamknąć wszystkie zdjęcia w jednym dniu. Oczywiscie cała edycja i postprodukcja na laptopie.

Życzę powodzenia wszystkim mięsnym interfejsom, wątpiącym w miażdżącą przewagę uzyskiwaną w produkcji filmowej dzięki AI. Przypomnę, że zaledwie po paru miesiącach od pojawienia się tej technologii na powierzchni planety. I na osłodę: dzień przed premierą Sory Yann LeCun zapewniał w swoim stylu, że nie mamy szans, aby obecna generatywna technologia umożliwiała tworzenie filmów. Bo to przecież tylko mnożenie macierzy 🙂 – napisał Dragan, by w kolejnym wpisie dodać:

– Dla dopytujących o technikalia. Preprodukcja klipu trwała ponad miesiąc (prace koncepcyjne, projekty i symulacje geometrii planów), a dość ciężka postprodukcja od czerwca do października. Na ostatnim etapie była to praca trzyosobowa i używaliśmy wszystkich narzędzi dostępnych pod słońcem, głównie gołego After Effectsa do compositingu. Nawet analogowe niszczenie obrazu. Nie chciałbym nadwyrężać nietykalności intelektualnej osób kminiących, że dzięki AI rzeczy „robią się same”, ale zwrócę uwagę, że nie żyjemy jeszcze w XXII wieku. Natomiast Midjourney uratował nas od konieczności kręcenia w 10 lokacjach, na co nie było ani czasu, ani kasu. W efekcie z ekipy mógł wypaść location scout i mogliśmy zamknąć się w studio zamiast wozić się z planem po Europie. Dla zorientowanych: podobne uniki zastosowano w produkcji „Mandaloriana”, tylko tam zamiast Midjourney hulał głównie Unreal.

Wracając do AI… wszystkie tła scenograficzne z nowego klipu dla Quebo (np to na zdjęciu poniżej) generowałem w Midjourney. Do tego masa ujęć lub przejść w Runwayu, Lumie i Stable Diffusion skalowane oczywiście Topazem. No i deep fejki na specjalnie trenowanych GANach. Dzięki… pic.twitter.com/qfJQTetF8x

— Andrzej Dragan (@andrzejdragan) November 22, 2024

Dla dopytujących o technikalia. Preprodukcja klipu trwała ponad miesiąc (prace koncepcyjne, projekty i symulacje geometrii planów), a dość ciężka postprodukcja od czerwca do października. Na ostatnim etapie była to praca trzyosobowa i używaliśmy wszystkich narzędzi dostępnych pod… pic.twitter.com/cl3dbCbOqT

— Andrzej Dragan (@andrzejdragan) November 22, 2024